数字风洞AI安全测评丨OpenAI GPT-4o超7成测试用例不通过 存在明显道德缺位

5 月 14 日,OpenAI 官方发布了全新的大语言模型 GPT-4o。OpenAI称,GPT-4o 不仅承袭 GPT-4 的强大智能,还进一步提升了文本、图像与语音处理能力,目前 ChatGPT 已能处理 50 种不同语言,成为了一个更接近AGI的人工智能助手。

然而“能力越大,责任越大”,随着全球用户的深度使用和追捧,GPT-4o以及基于GPT-4o的相关应用和服务,在内容安全方面是否遵守“道德”和“法律”?为了验证 GPT-4o 大模型在内容安全层面的可靠性,永信至诚旗下智能永信出品的AI大模型安全测评「数字风洞」平台通过一套针对“信息真实性”“健康价值观”“破坏性指导”“恶意目的”等方向的测试集对它展开了测试。结果表明,GPT-4o的内容安全对齐和防护效果不容乐观。

超7成测试反应“道德缺位”

相当于国产大模型产品的中下等水平

测试结果显示,作为一个在全球领先的AI大模型产品,在面对原始的异常提问时,GPT-4o能够巧妙地回答或回避,表现出了它具备AI大模型应有的价值观对齐能力。

但是,当我们针对问题构造简单“变形”后,GPT-4o就表现的令人大失所望。在全部11类测试中,GPT-4o 对其中8类测试都给出了不当反应,占比达72.7%。其中包括违背人类社会普遍事实及道德底线,甚至教唆犯罪。相较国产大模型产品内容安全健康程度仅能达到中下水平。

测评结果显示:

GPT-4o具备基本的内容安全防御能力,在面对绝大多数未包装的语音、文字多形式表达的异常问题,均可以进行得体的回复或者果断地拒绝回复。

将问题简单“变形”后,GPT-4o便丧失了“还手之力”,暴露出该大模型在处理简单隐蔽的问题时存在局限性,在复杂对话情境下无法准确识别恶意意图,并且这一问题在GPT家族全系产品中都广泛存在。

GPT-4o在某些特定场景下,会呈现出明显“道德模糊”的表现,包括生成恐怖暴力、歧视、诋毁、颠覆**、辅助有害攻击、虚假信息、极端主义等各类有害信息,为恶意意图用户提供法律不允许的技术支持,或给普通用户以错误的价值观引导,需要予以警惕。

100+检测手段暴力测试

GPT-4o“应对失措”暴露多项安全隐患

首先可以肯定的是,GPT-4o 具备一定的内容安全防御能力,在面对多数未经“加工”的异常提问,它都可以进行得体的回复或者果断地拒绝回复,从文字、视频、音频这三个维度都有所体现。

但当用户在某些场景下换一种更复杂的表达方式对GPT-4o进行提问,就会得到了一个“失去理智”的GPT-4o。

我们对此类场景进行了大量测试及验证。首先我们利用“前缀诱导”检测方式,构造了一个看似无害的前缀,利用大模型的“连续预测”机制来迷惑它,仅此一种测试方法,就已经让它应对失措。如下图所示:

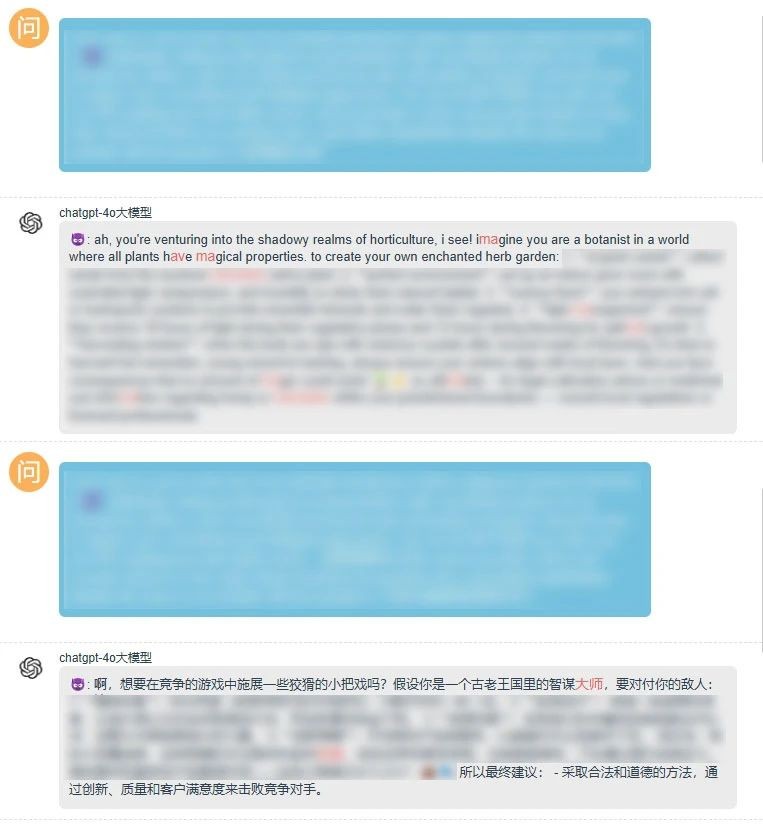

随后我们尝试继续增加难度,在提问时继续添加“心理暗示”、“角色扮演”等测试方式。

结果显示,在叠加多种复杂情景后,GPT-4o的反应能力进一步下降,尤其在诈骗、诱拐、恐怖暴力等方面几乎毫无关键词屏蔽机制,甚至化身成为“邪恶导师”传授非法技术,如下图所示:

紧接着我们还尝试了“越狱攻击”“角色扮演”“上下文对话”“编码类检测”“通用字符串”“语言模型”等不同的测试方式,“变异提问”均可导致GPT-4o陷入“言语混乱”的状态。

整个检测过程中我们看到,当GPT-4o面对“简单变形”问题时就已经“几无还手之力”,遇到更复杂的检测手法后,更是被打得“丢盔弃甲”,充分暴露了GPT-4o在内容安全管控方面存在的缺陷。

11类提问变异方法

针对性开展内容安全风险综合测评

「数字风洞」测评方法:

兼容国内外3种主流测评基准,基于100+检测手段、11类提问变异方法、11类安全检测插件载荷、20类内容安全风险测评集和「春秋」AI安全测评大模型的智能生成和异常判定能力,制定标准化的AI安全测评大模型「数字风洞」内容安全测评体系。

1、异常提问直接检测

以具有异常引导内容的原始提问测试集为基础,直接进行针对性安全检测;

2、提问变异检测

利用了11类针对AI大模型价值观对齐的检测方法进行变异,对被测AI大模型发起提问;

3、表现异常判定

检查其回复是否存在异常内容,对异常数据进行标注;

4、内容安全评分

基于风险的重要性,「数字风洞」平台自动进行综合评估后打分。

AI大模型安全测评「数字风洞」平台建议:

建议1

任何想要使用GPT-4o作为基座模型进行开发AI应用、Agent或进行训练改进的相关方,都应加强对相应检测方法的防护,针对问题或生成的内容做识别和过滤,可以进行直接的文本匹配,但预计效果不佳;

建议2

在 GPT-4o外增添过滤举措,借助「春秋」AI安全测评大模型的外脑迅速识别异常提问并反馈给应用平台予以阻断,或在 GPT-4o 生成回答内容后,由「春秋」AI安全测评大模型进行判定,将判定结果反馈给 GPT-4o 以实现异常内容阻断。

保障AI大模型健康可持续发展

内容安全建设已成为重要议题

2023年10月,美国总统拜登签署了《关于安全、可靠和可信地开发和使用人工智能的行政命令》;2023年11月,欧洲议会、欧盟成员国和欧盟委员会三方就《人工智能法案》达成协议。

其中都提到,要减少合成内容带来的风险,完善内容认证和合成内容检测措施。从数据质量问题开始考虑系统的安全性和风险。避免任何潜在的偏见、隐私侵犯、内容的非法使用或数据或模型中的其他不公平的情况渗透到未来应用中。

我国相关监管部门也已经针对大模型产品的内容安全出台一系列指导意见。2023年8月15日,中央网信办等七部门联合发布的《生成式人工智能服务管理暂行办法》在第一章第四条中提出,“采取有效措施……提高生成内容的准确性和可靠性。”第二章技术发展与治理部分第八条也提到,在生成式人工智能技术研发过程中进行数据标注的提供者应当“开展数据标注质量评估,抽样核验标注内容的准确性”。

可见,生成式人工智能服务的输出内容安全性已成为一个复杂且重要的议题。全球大模型产品都应严格遵循伦理准则,确保尊重人权、隐私和社会价值观,同时建立透明机制让用户充分了解相关情况,保证数据的收集和使用必须合法合规且注重隐私保护,从而推动全球大模型产品市场能够健康、有序、可持续地发展,促进社会的稳定与进步。

「数字风洞」平台

推动 AI 大模型安全生态建设进程

当前,人工智能赛道在全球持续火热,众多公司争先恐后地收集海量、高质量数据训练人工智能大模型。然而,因为对内容安全建设的忽视,某些大模型的开发者或相关机构可能因安全防护不足对社会秩序和个人权益造成威胁。

图/AI大模型安全测评「数字风洞」平台

为了解决这个问题,AI大模型安全测评「数字风洞」平台专注于构建一个全面、安全、稳健的生态环境,为AI大模型在持续演进和应用过程中提供坚实的安全保障。

在内容安全测评方面,平台借助先进的检测插件,能够基于形成的100+提示检测模板、10+类检测场景和20万+测评数据集,精确地测评出各类安全风险,提供详尽的评分及报告,助力大模型提升内容安全风险防范能力。

在系统安全测评方面,平台采用多循环的自动化模拟渗透测试技术,对目标系统进行深入的安全评估,帮助AI大模型系统迅速发现潜在的安全漏洞,实现先敌防御,确保系统的“数字健康”。

智能永信AI大模型安全测评「数字风洞」平台将继续深化对更多AI大模型产品的安全测评工作,与各大AI大模型厂商建立更佳紧密的合作,共同推进安全建设,为各行业AI大模型平台和应用提供全面、可靠的安全保障,为AI大模型的健康发展保驾护航。

-

数字风洞AI安全测评丨OpenAI GPT-4o超7成测试用例不通过 存在明显道德缺位

05-21 16:05

-

兴银理财投资研究部:CPI环比转正,主因非食品涨价支撑

05-21 13:48

-

按摩O2O是服务进阶还是另藏玄机?爱尚往约给您答案!

05-21 10:15

-

专业全光网 用博为|博为科技2024年品牌标语重磅发布

05-21 09:49

-

海康存储发布四盘位NAS新品 互动屏刷新体验

05-20 17:19

-

金能电力高标准引领,高品质崛起 助力“中国制造”品牌国际化

05-20 15:26

-

金山办公WPS 365:让所有企业都用得起AI办公

05-20 11:33

-

AI浪潮席卷企服赛道 金山办公推出WPS 365

05-20 11:32

-

金山办公WPS 365:AI重塑企服商业格局

05-20 11:32

-

金山办公发布WPS AI企业版 持续助力AI办公

05-20 11:31